Czy powinno martwić nas to, że sztuczna inteligencja błędnie odczytuje ludzkie emocje?

Podczas gdy system rozpoznawania twarzy próbuje zidentyfikować konkretną osobę, rozpoznawanie afektu (ekspresji emocji) ma na celu wykrycie i sklasyfikowanie emocji poprzez analizę dowolnej twarzy. Obecnie urządzenia do rozpoznawania twarzy oraz występujących na niej emocji można znaleźć w systemach bezpieczeństwa narodowego, na lotniskach i w sektorze edukacji. Bywają też używane w procesie rekrutacji do niektórych firm oraz w programach policyjnych, które mają rzekomo przewidzieć zachowanie przemocowe.

Systemy rozpoznawania emocji zakładają, że istnieje niewielka liczba odrębnych i uniwersalnych kategorii emocjonalnych oraz że emocje, które mimowolnie pokazujemy na naszych twarzach, mogą zostać wykryte przez maszyny.

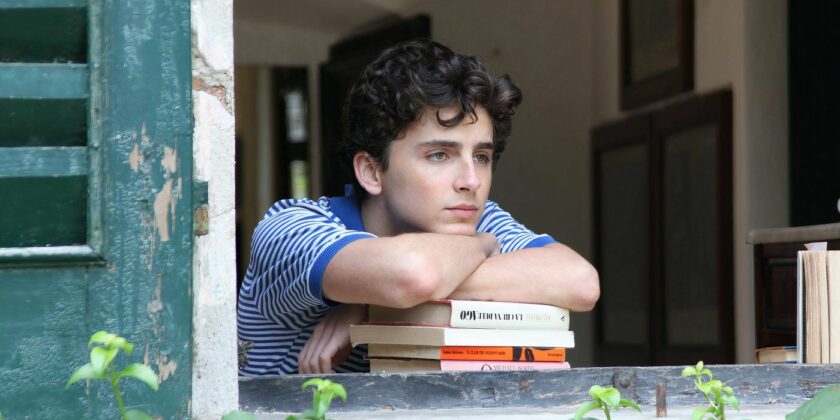

Uśmiech nie zawsze oznacza radość.

Emocje a mimika

Twierdzenie, że stan wewnętrzny danej osoby można dokładnie ocenić, analizując jej twarz, opiera się na niepewnych dowodach. Badanie prowadzone przez psycholożkę i neurobiolożkę Lisę Feldman Barrett wykazało, że nie ma wiarygodnych dowodów na to, że w ten sposób można precyzyjnie określić czyjś stan emocjonalny.

– Nie można z przekonaniem wywnioskować szczęścia z uśmiechu, gniewu z grymasu czy smutku z tzw. podkówki, tak jak próbuje zrobić wiele obecnych technologii, błędnie uznając to za fakty naukowe. Firmy mogą mówić, co chcą, ale dane są jasne. Potrafią wykryć grymas, ale to nie to samo, co wykrywanie gniewu – podsumowuje badanie Barrett.

Silvan Tomkins, który w latach 60. był uznanym psychologiem w Princeton, założył, że okazywanie afektów na twarzy jest uniwersalną ludzką cechą. Uważał je za zestawy reakcji mięśniowych, naczyniowych i gruczołowych zlokalizowanych na twarzy, a także szeroko rozprowadzanych po całym ciele, które generują czuciowe sprzężenie zwrotne. Te zorganizowane zestawy odpowiedzi są wyzwalane w ośrodkach podkorowych, gdzie przechowywane są określone 'programy’ dla każdego odrębnego afektu. Interpretacja pokazów afektywnych zależy od czynników indywidualnych, społecznych i kulturowych, ponieważ w różnych społeczeństwach istnieją różne odmiany języka twarzy.

Photo by Fleur Kaan/Unsplash.com

Jako że mimika jest czymś zależnym od kultury, używanie jej do trenowania systemów uczenia maszynowego powoduje nieuchronne wymieszanie różnych kontekstów, sygnałów i oczekiwań.

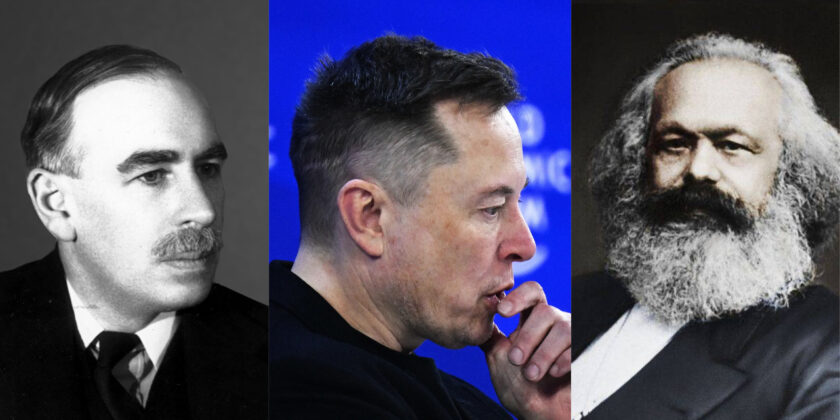

Dlaczego więc pomysł, że istnieje pewien zestaw uniwersalnych emocji, łatwo interpretowanych z twarzy osoby, został tak szybko zaakceptowany i zaaprobowany w dziedzinie sztucznej inteligencji? Firmy technologicznie poniekąd chcą wierzyć, że tak jest, ponieważ sama idea automatycznego rozpoznawania emocji i form ich ekspresji wydaje się bardzo przekonująca i dochodowa. Branżowi giganci szybko zajęli się analizą tego, co mieli na ten moment dostępne – miliardy selfie na Instagramie, zdjęcia na Pintereście czy Flickrze oraz filmy na TikToku. Podobnie jak rozpoznawanie twarzy, rozpoznawanie afektów stało się częścią podstawowej infrastruktury wielu firm, od tych największych po małe start-upy.

Systemy te już teraz stosowane są choćby w instytucjach publicznych, mimo braku istotnych dowodów naukowych, że w ogóle działają.

Dlaczego ktoś chce poznać twoje emocje?

Zautomatyzowane systemy wykrywania afektów są obecnie szeroko stosowane, zwłaszcza przy zatrudnianiu. Firma AI HireVue, która przeprowadza procesy rekrutacyjne dla takich firm jak Goldman Sachs, Intel czy Unilever, wykorzystuje uczenie maszynowe, aby określić, czy ludzie nadają się do pracy. Już w 2014 roku używała specjalnego systemu opartego na AI, który służył do wyodrębniania zmian w mimice kandydata, jego tonie głosu oraz wszelkich innych zmiennych podczas przeprowadzania rozmowy kwalifikacyjnej. Następnie system porównywał kandydatów do najlepszych pracowników firmy.

W tym roku, po szerokiej krytyce ze strony naukowców i organizacji zajmujących się prawami obywatelskimi, firma zrezygnowała z analizy twarzy, ale nadal bada ton głosu i wykorzystuje jako kryterium oceny kandydatów.

W tej branży powstało wiele start-upów. Jednym z największych jest zdecydowanie bostońska Affectiva, która współtworzyła wiele aplikacji związanych z emocjami, zwłaszcza przy użyciu technik uczenia maszynowego, głównie deep learning. Wśród nich znalazły się m.in. takie, które mają za zadanie wykryć rozproszonych i potencjalnie niebezpiecznych kierowców na drogach lub mierzyć emocjonalne reakcje konsumentów na reklamę. Firma twierdzi również, że zbudowała coś na wzór największej na świecie bazy danych emocji, składającej się z ponad 10 mln afektów osób z 87 krajów.

Photo by Alessandro Bellone/Unsplash.com

System rozpoznawania emocji jest stosowany również w jednej ze szkół w Hongkongu – True Light College. Jej uczniowie, podobnie jak inne dzieci na całym świecie, przez ostatni rok musieli uczyć się z domu. Oni jednak byli obserwowani podczas nauki przy swoich biurkach– obraz z kamer ich komputerów był przechwytywany, a następnie analizowany przez specjalne oprogramowanie o nazwie 4 Little Trees. Ten system oparty na sztucznej inteligencji miał odczytywać emocje uczniów podczas nauki. Z założenia miało to pomóc nauczycielom w sprawieniu, aby nauczanie zdalne było bardziej interaktywne i spersonalizowane dzięki reagowaniu na bodźce przesyłane przez poszczególnych uczniów w czasie rzeczywistym.

Algorytm 4 Little Trees mierzy mikroruchy mięśni na twarzach uczniów i próbuje zidentyfikować emocje, takie jak szczęście, smutek, złość, zaskoczenie i strach. Firma twierdzi, że algorytmy generują szczegółowe raporty dotyczące stanu emocjonalnego każdego ucznia, które otrzymują nauczyciele, a także mogą mierzyć motywację i koncentrację.

Nie tylko pojedyncze start-upy interesują się tą nową technologią – rozwijają ją również giganci z Doliny Krzemowej.

Amazon, Microsoft czy IBM już posiadają swoje systemy do wykrywania emocji. Microsoft oferuje taką usługę w swoim interfejsie Face API, identyfikując gniew, pogardę, wstręt, strach, szczęście, neutralność, smutek i zaskoczenie, podczas gdy narzędzie Amazon Rekognition może zidentyfikować 'wszystkie siedem emocji’ i zmierzyć to, jak szybko zmieniają się u użytkownika.

Niektóre grupy są wyjątkowo poszkodowane.

Niebezpieczeństwa związane z systemem rozpoznawania emocji

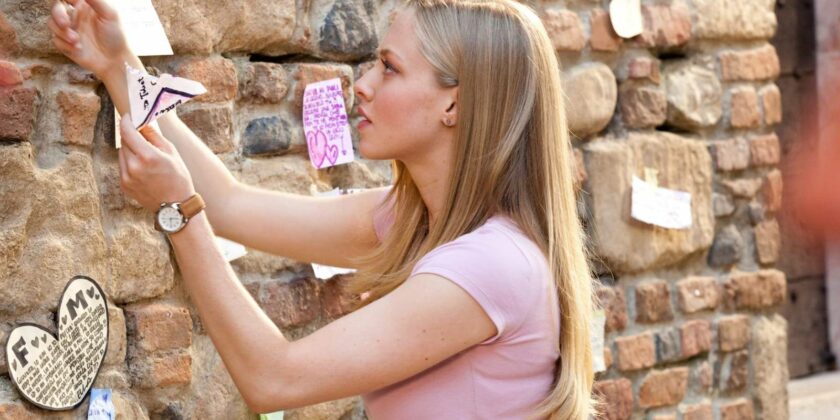

Amerykańska Administracja ds. Bezpieczeństwa Transportu od ataku z 11 września 2001 roku korzysta ze SPOT (Screening of Passengers by Observation Techniques). System używany jest do monitorowania wyrazów twarzy pasażerów lotniczych, w celu automatycznego wykrywania terrorystów. Ta technologia wykorzystuje 94 kryteria, z których wszystkie są rzekomo oznakami stresu, strachu lub oszustwa. Stąd wynika, że każdy, kto jest zestresowany, czuje się niekomfortowo podczas przesłuchania lub ma negatywne doświadczenia z policją i strażą graniczną, może uzyskać wyższy wynik oraz stać się automatycznie podejrzanym.

Ryzyko celowego nadużycia, nie tylko w przypadku profilowania rasowego, jest dość oczywiste. Mniej oczywista jest perspektywa fatalnych błędów – na przykład zastrzelenie kogoś, ponieważ system identyfikuje go jako bezpośrednie zagrożenie terrorystyczne.

Program SPOT został skrytykowany przez Rządowe Biuro Odpowiedzialności (GAO) oraz organizacje działające na rzecz wolności obywatelskich za rasistowskie uprzedzenia i brak metodologii naukowej. Badanie przeprowadzone na Uniwersytecie Maryland wykazało, że zdaniem niektórych programów do rozpoznawania twarzy więcej negatywnych emocji wywołują twarze osób czarnych niż białych. Programy rejestrują je jako bardziej rozgniewane i pogardliwe, nawet jeśli widoczny jest na nich uśmiech.

Photo by Jakayla Toney/Unsplash.com

Automatyzacja rozpoznawania emocji niesie za sobą wiele niebezpieczeństw. Takie podejście oraz narzędzia gwarantują nam powrót do przeszłości, kiedy to fałszywe twierdzenia były wykorzystywane do wspierania istniejących systemów władzy oraz szerzenia błędnych teorii. Za przykład może posłużyć popularna w XVIII i XIX wieku frenologia, według której zdolności człowieka i jego cechy psychiczne zależą od kształtu czaszki. Emocje są skomplikowane – rozwijają się i zmieniają w zależności od kultury, historii oraz wszelkich innych, różnorodnych kontekstów, których zrozumienie wykracza poza dotychczasowe umiejętności sztucznej inteligencji. Jeśli my jako ludzie nie jesteśmy w stanie naprawdę wyrazić tego, co czujemy, to dlaczego miałyby to wiedzieć systemy oparte na AI?

Przecież czasami nawet matka nie wie, dlaczego jej dziecko płacze. Widzi tylko grymas na twarzy, za którym może się kryć wiele różnych emocji.

Już teraz za sprawą istniejących algorytmów kandydaci do pracy są niesprawiedliwie oceniani, ponieważ ich wyraz twarzy lub ton głosu nie pasuje do cech innych pracowników. Uczniowie wyróżniają się w szkole, ponieważ ich twarze nie wyglądają tak jak powinny, a klienci są przeszukiwani i przesłuchiwani tylko dlatego, że ich mimika rzekomo wskazuje, że mogą być złodziejami. Ci ludzie ponoszą koszty systemów, które są nie tylko niedoskonałe technicznie, ale przede wszystkim są oparte na wątpliwych metodologiach.

Jeszcze bardziej niepokojące jest to, że w dziedzinie badania emocji naukowcy nie osiągnęli nawet konsensusu co do tego, czym właściwie jest emocja. Czym są emocje? Jak są w nas formułowane i wyrażane? Jakie mogą być ich funkcje fizjologiczne lub neurobiologiczne? Ich stosunek do bodźców? Naukowcy nie są zgodni. Więc dlaczego AI miałoby sobie radzić z naszymi emocjami?

Tekst: MZ

121k

121k