Sztuczna inteligencja odtworzyła obrazy, na które patrzyli ludzie. Zrobiła to, analizując ich fale mózgowe

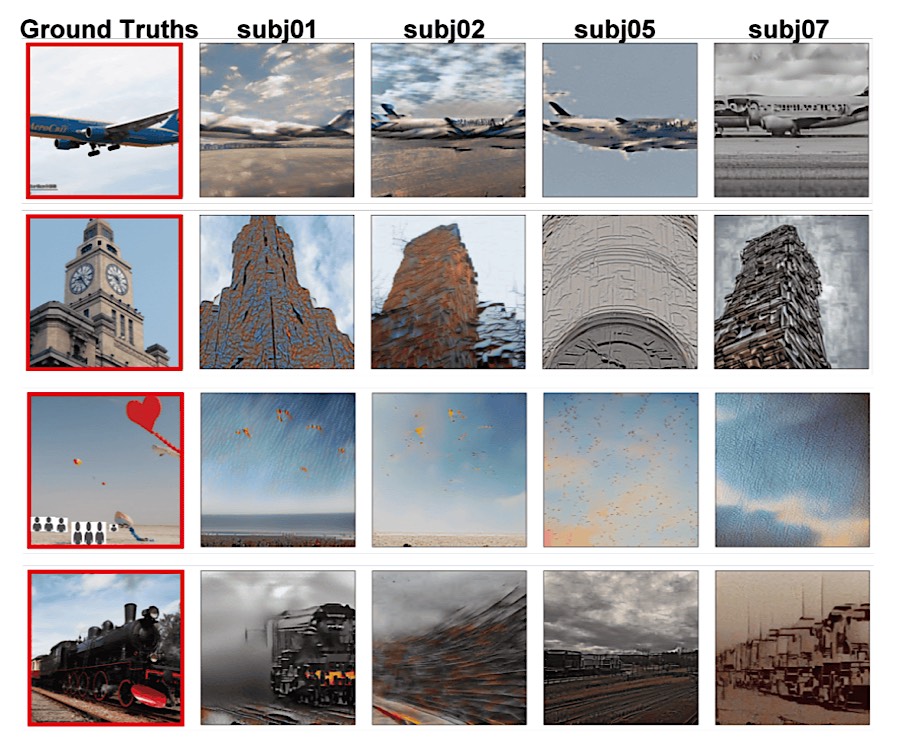

Programy generatywnej sztucznej inteligencji są coraz lepsze w konstruowaniu imponująco szczegółowych obrazów na podstawie wprowadzanych danych tekstowych, ale naukowcy z japońskiego Uniwersytetu w Osace zrobili duży krok naprzód. Nauczyli sztuczną inteligencję rekonstruowania dokładnych obrazów o wysokiej rozdzielczości na podstawie aktywności ludzkiego mózgu – fal generowanych podczas patrzenia na obrazy.

Aby eksperyment miał jeszcze większą szansę powodzenia, naukowcy połączyli tysiące opisów tekstowych zdjęć z tym, co wyobrażali sobie w danym momencie ochotnicy biorący udział w badaniu. Aktywność ich mózgów była skanowana przy pomocy funkcjonalnego rezonansu magnetycznego (fMRI).

Poziomy przepływu krwi w mózgu zmieniają się w zależności od tego, które obszary są aktywowane.

Na przykład krew przemieszczająca się do płatów skroniowych pomaga w dekodowaniu informacji o ‘zawartości’ obrazu. Naukowcy postanowili więc ‘nakarmić’ sztuczną inteligencję danymi w postaci skanów fMRI wygenerowanych przez cztery osoby przeglądające ponad 10 tys. obrazów, a następnie dodać ich opisy tekstowe i słowa kluczowe. Pozwoliło to algorytmom nauczyć się, jak przekładać odpowiednią aktywność mózgu na treści wizualne.

Jak to wyglądało w praktyce? Gdy podczas testów człowiek patrzył na obraz wieży zegarowej, sztuczna inteligencja korzystała z wcześniej wprowadzonych słów kluczowych dotyczących tej wizualizacji. Obraz był dodatkowo wzbogacany o szczegóły, które były odczytywane z układu płata potylicznego i informacji perspektywicznych, przesyłanych przez mózg.

To przełomowe badanie jest niezwykle obiecujące w obszarach takich jak neuronauka poznawcza.

Magazyn Science zauważa, że pewnego dnia może nawet pomóc naukowcom zacząć odczytywać i zrozumieć to, jak inne gatunki postrzegają otaczające je środowisko.

Tekst: MZ