Architekt interpretacji. Co to za nowy zawód?

Świat pracy wchodzi w fazę głębokiej transformacji napędzanej przez sztuczną inteligencję, automatyzację i robotykę. Coraz więcej zadań analitycznych, operacyjnych i organizacyjnych jest przejmowanych przez systemy obliczeniowe, które potrafią szybciej i taniej przetwarzać dane, wykrywać wzorce oraz generować rekomendacje. W tej sytuacji rola człowieka nie znika, ale zmienia swój charakter.

Maleje znaczenie pamięciowego opanowania procedur i faktów, rośnie znaczenie umiejętności interpretacji, łączenia informacji z różnych domen, rozumienia niepewności oraz podejmowania decyzji w oparciu o modele probabilistyczne.

Odpowiedzią na tę zmianę mógłby być nowy kierunek studiów skoncentrowany na zarządzaniu niepewnością, integrujący sztuczną inteligencję, probabilistykę, kognitywistykę oraz nauki o decyzji. Taki kierunek byłby zbudowany wokół założenia, że rzeczywistość społeczna, ekonomiczna i technologiczna ma charakter rozkładowy, a nie deterministyczny. Zamiast uczyć jednego poprawnego modelu świata, uczyłby operowania na wielu modelach jednocześnie, rozumienia ich ograniczeń oraz szacowania poziomu wiarygodności wniosków. Absolwent nie byłby klasycznym programistą ani klasycznym analitykiem danych, lecz architektem interpretacji, osobą zdolną do współpracy z systemami AI, zadawania im właściwych pytań i krytycznej oceny odpowiedzi.

Rdzeniem programu musiałyby być solidne podstawy matematyczne i statystyczne. Studenci uczyliby się rachunku prawdopodobieństwa, statystyki bayesowskiej, teorii decyzji oraz modelowania niepewności.

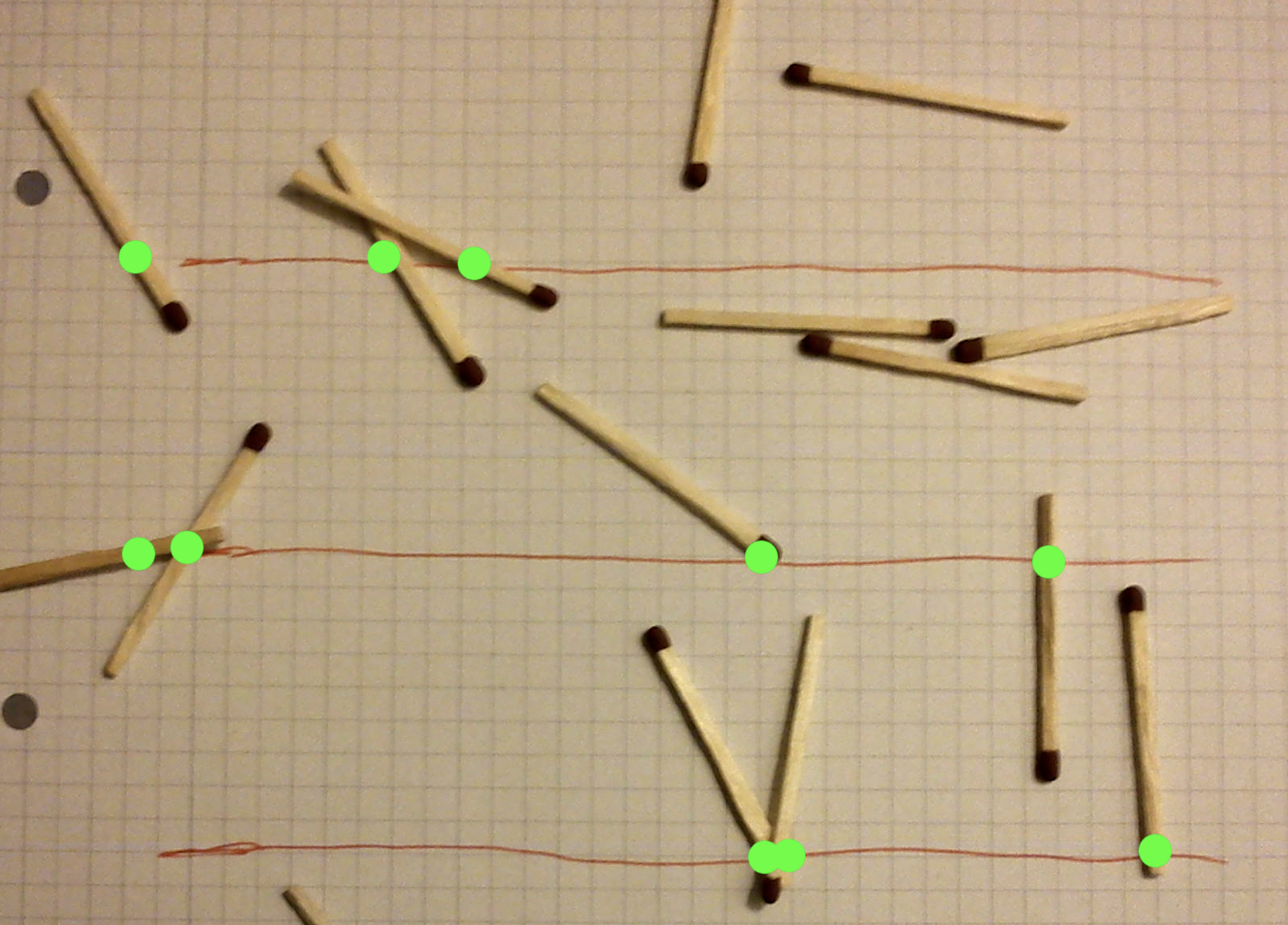

Ważną częścią byłyby rozkłady prawdopodobieństwa, wnioskowanie bayesowskie, estymacja parametrów, testowanie hipotez oraz analiza błędu. Program obejmowałby także metody symulacyjne, w tym symulacje Monte Carlo, techniki próbkowania, łańcuchy Markowa oraz metody bootstrap. Celem nie byłoby tylko rozwiązywanie zadań rachunkowych, lecz budowanie intuicji rozkładowej, rozumienia, że każdy wynik ma zakres ufności i warunki brzegowe. Drugim filarem byłoby probabilistyczne uczenie maszynowe. Obejmowałoby ono modele generatywne, procesy Gaussa, probabilistyczne modele graficzne, ukryte modele Markowa oraz programowanie probabilistyczne. Studenci poznawaliby różnice między modelami deterministycznymi i probabilistycznymi, uczyliby się, jak reprezentować niepewność w modelach oraz jak ją propagować przez kolejne etapy wnioskowania. Ważnym elementem byłaby także kalibracja modeli i ocena wiarygodności predykcji, a nie tylko maksymalizacja trafności. Trzecim blokiem byłaby praktyczna praca z systemami sztucznej inteligencji, w tym z modelami generatywnymi. Studenci uczyliby się projektowania zapytań do modeli, strategii promptowania, iteracyjnego doprecyzowywania poleceń oraz oceny jakości odpowiedzi.

Kluczowe byłoby rozumienie, że model generuje rozkład możliwych odpowiedzi, a nie jedną prawdę.

Zajęcia obejmowałyby analizę halucynacji modeli, błędów systematycznych, stronniczości danych treningowych oraz metod redukcji ryzyka błędnej interpretacji. Praca z AI byłaby traktowana jak dialog z systemem probabilistycznym, a nie jak korzystanie z kalkulatora. Czwarty filar to kognitywistyka i nauki o umyśle. Kierunek zarządzania niepewnością musiałby uwzględniać to, jak ludzie faktycznie podejmują decyzje, jak przetwarzają informacje i jak reagują na ryzyko. Program obejmowałby podstawy neuronauki poznawczej, teorii uwagi, pamięci i percepcji oraz współczesne modele umysłu predykcyjnego. Studenci poznawaliby pojęcie błędu predykcji, modele mózgu jako systemu prognozującego oraz ograniczenia ludzkiej racjonalności. Dzięki temu lepiej rozumieliby zarówno zachowanie użytkowników systemów AI, jak i własne ograniczenia poznawcze.

Istotnym komponentem byłaby także psychologia decyzji i psychologia kliniczna w zakresie oceny niepewności, ryzyka i błędów poznawczych.

Omawiane byłyby heurystyki i błędy decyzyjne, nadmierna pewność siebie, efekt potwierdzenia, awersja do straty oraz zjawiska paniki i irracjonalnej eskalacji zaangażowania. Wiedza ta jest kluczowa, ponieważ zarządzanie niepewnością nie polega tylko na pracy z modelami, lecz także na pracy z ludźmi, którzy te modele interpretują i na ich podstawie działają. Kolejny blok powinien dotyczyć teorii systemów złożonych i dynamiki nieliniowej. Współczesne problemy gospodarcze i społeczne rzadko są liniowe i w pełni przewidywalne. Studenci uczyliby się o sprzężeniach zwrotnych, punktach krytycznych, emergencji oraz modelach agentowych. Poznawaliby symulacje wieloagentowe, modele sieciowe oraz podstawy teorii gier. Dzięki temu potrafiliby analizować sytuacje, w których lokalne decyzje prowadzą do globalnych, nieoczekiwanych skutków. Bardzo ważnym elementem kierunku byłyby kompetencje miękkie, ale rozumiane technicznie, a nie ogólnikowo. Obejmowałyby komunikację niepewności, czyli umiejętność wyjaśniania rozkładów, scenariuszy i ryzyk osobom nietechnicznym. Studenci ćwiczyliby przekładanie wyników modeli probabilistycznych na język decyzji biznesowych i publicznych. Uczyliby się, jak mówić o przedziałach ufności, scenariuszach i ryzyku bez wprowadzania fałszywej pewności ani niepotrzebnej paniki.

Program powinien też zawierać moduł etyki i odpowiedzialności w środowisku decyzji wspieranych przez AI.

Obejmowałby on kwestie odpowiedzialności za decyzje oparte na modelach, sprawiedliwości algorytmicznej, przejrzystości oraz granic automatyzacji. Studenci analizowaliby przypadki, w których ślepe zaufanie modelom prowadziło do błędów systemowych. Uczyliby się projektować procesy decyzyjne, w których człowiek zachowuje rolę krytycznego nadzorcy. Nieodzowny byłby też komponent projektowy. Studenci pracowaliby nad realnymi problemami, w których dane są niepełne, zaszumione i sprzeczne. Projekty polegałyby na budowie modeli, ale też na interpretacji ich wyników i rekomendacjach działań. Oceniana byłaby nie tylko trafność predykcji, lecz także jakość uzasadnienia i świadomość ograniczeń modelu.

Promowana byłaby kultura raportowania niepewności zamiast jej ukrywania.

Ważnym uzupełnieniem byłaby edukacja w zakresie integracji wiedzy z wielu źródeł. Studenci uczyliby się metod łączenia sygnałów z danych ilościowych, jakościowych, eksperckich i modelowych. Poznawaliby metody wnioskowania przyczynowego, analizę scenariuszową oraz techniki budowy map argumentów. Celem byłoby wykształcenie umiejętności łączenia kropek, czyli budowania spójnego obrazu z fragmentarycznych informacji. Kierunek zarządzania niepewnością powinien też uwzględniać elementy programowania, ale ukierunkowane na eksperymentowanie i modelowanie, a nie tylko inżynierię oprogramowania. Studenci uczyliby się narzędzi do symulacji, analizy danych, budowy modeli probabilistycznych i pracy z bibliotekami AI. Programowanie byłoby narzędziem myślenia modelowego, a nie celem samym w sobie.

Profil absolwenta takiego kierunku to osoba, która rozumie, że wynik modelu jest rozkładem możliwości, potrafi zaprojektować dialog z systemem AI, krytycznie ocenić odpowiedź, połączyć ją z wiedzą z innych domen i przełożyć na decyzję. To specjalista od interpretacji i integracji, nie tylko od obliczeń. W świecie, w którym wiele czynności wykonają maszyny, taka rola będzie kluczowa.