chatGPT zdał test Turinga

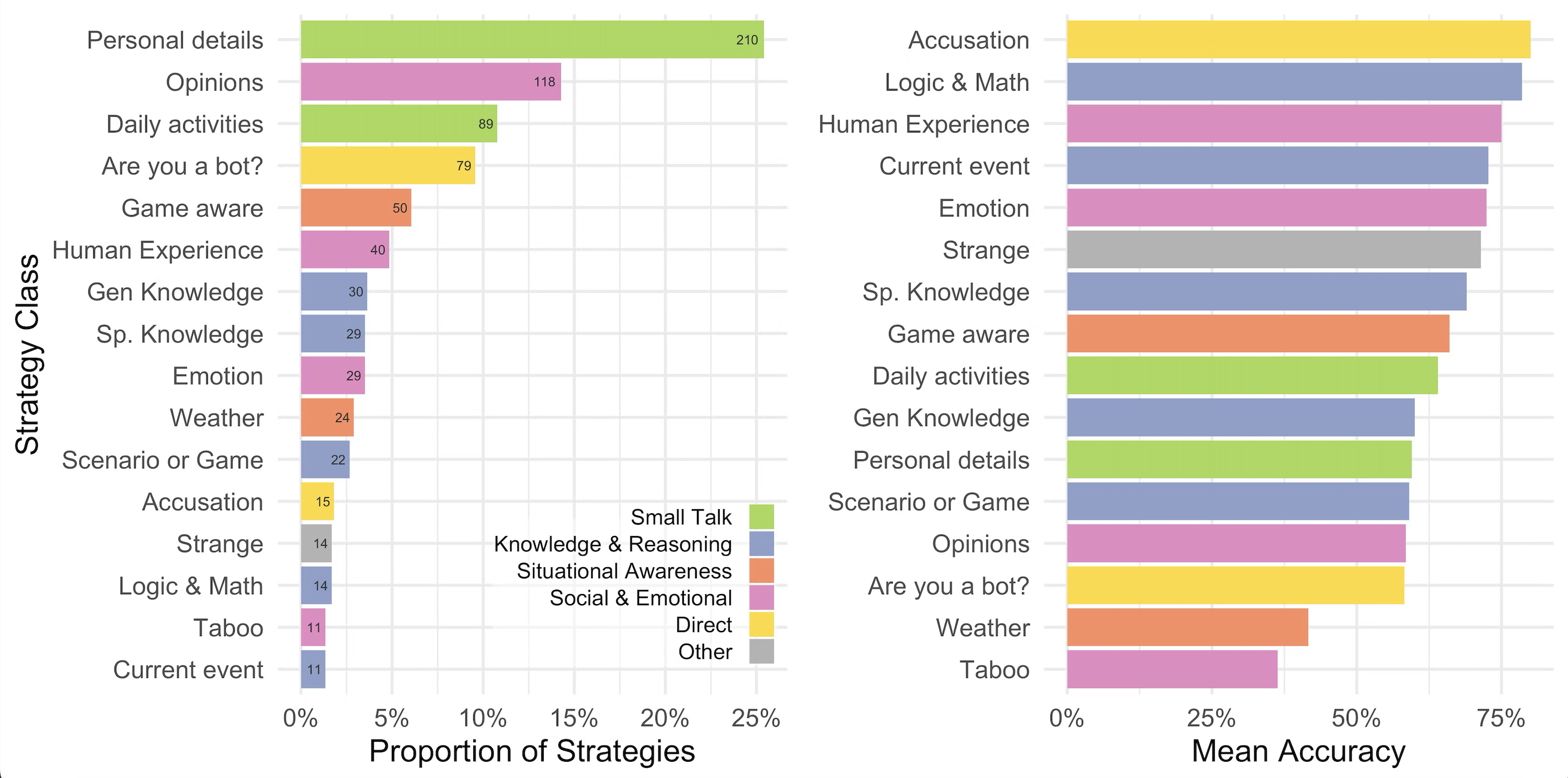

W badaniu wzięło udział 284 uczestników, którzy pełnili role sędziów. Każdy z nich prowadził jednocześnie pięciominutowe rozmowy tekstowe z dwoma rozmówcami: jednym człowiekiem i jednym modelem językowym (LLM). Po zakończeniu rozmów sędziowie mieli wskazać, który z rozmówców był człowiekiem. W eksperymencie testowano cztery modele językowe: ELIZA — historyczny chatbot z lat 60., GPT-4o — wcześniejsza wersja modelu GPT, LLaMa-3.1-405B — model opracowany przez firmę Meta, GPT-4.5 — najnowszy model od OpenAI.

GPT-4.5 został błędnie uznany za człowieka w 73% przypadków i był częściej uznawany za człowieka niż rzeczywisty ludzki rozmówca, co stanowi przełom w historii testów Turinga.

Przejście testu Turinga przez GPT-4.5 nie oznacza, że model ten posiada świadomość czy rozumienie na poziomie człowieka. Oznacza to jednak, że potrafi on naśladować ludzką konwersację na tyle skutecznie, że jest trudny do odróżnienia od prawdziwego człowieka w krótkiej interakcji tekstowej.Badacze podkreślają, że sukces GPT-4.5 w teście Turinga ma istotne implikacje dla przyszłości interakcji człowiek–maszyna, zwłaszcza w kontekście etyki, dezinformacji i bezpieczeństwa.

Test Turinga, zaproponowany przez Alana Turinga w 1950 roku, ma na celu ocenę zdolności maszyny do naśladowania ludzkiego zachowania w sposób nieodróżnialny dla człowieka.

W klasycznej wersji testu bierze udział trzech uczestników: sędzia (człowiek), człowiek i maszyna. Sędzia prowadzi rozmowy z pozostałymi dwoma, nie wiedząc, kto jest kim, i ma za zadanie określić, który z rozmówców jest człowiekiem. Jeśli maszyna potrafi przekonać sędziego, że jest człowiekiem, uważa się, że przeszła test.

141k

141k