Coco i Cloak będą groźniejsze niż fake newsy. „Mamy przerąbane” – mówi autor „Infokalipsy”

Jak wyglądają perspektywy na najbliższą przyszłość w zakresie zwalczania fake newsów oraz szanse na globalny dostęp do możliwie rzetelnych, obiektywnych informacji? Powiedzieć, że sytuacja nie rysuje się różowo, to i tak zbyt duży eufemizm. Aviv Ovadya już w 2016 roku, przed wyborami w USA, próbował nagłośnić problem nieprawdziwych treści w sieci w prezentacji zatytułowanej „Infokalipsa”. Mówił wtedy wprost, że dzięki coraz powszechniejszemu dostępowi użytkowników internetu do zaawansowanych narzędzi oraz błyskawicznemu rozwojowi AI, sytuacja wkrótce może wymknąć się spod czyjejkolwiek kontroli.

Ovadya zwrócił się wówczas bezpośrednio między innymi do największych „graczy” na społecznościowym rynku, podkreślając że Facebook, Twitter czy Google priorytetowo traktują kliknięcia, udostępnienia, reklamy i pieniądze, podczas gdy wiarygodność informacji często spychają na drugi plan. Tym samym nasza podatność na manipulacje, dezinformację, a nawet wyrachowane prowokacje ze strony obcych państw jest bardzo duża. Niestety większość z adresatów tego alarmu (w tym ustawodawcy, dziennikarze czy prezesi kluczowych firm) zdała sobie sprawę z jego słuszności dopiero po kilku miesiącach.

Co gorsza, spoglądając w przyszłość Ovadya nie owija w bawełnę. – Mamy tak przerąbane, że to wykracza poza wyobraźnię większości z nas – mówi.

Gdzie dopatruje się on największych niebezpieczeństw?

Przede wszystkim w gwałtownym rozwoju sztucznej inteligencji, a także powstawaniu ogromnej liczby programów i aplikacji umożliwiających manipulację informacjami, obrazem, dźwiękiem czy wideo na szeroką skalę. Ale i w znacznie subtelniejszych technikach, które stopniowo – często w skali masowej – dają przyzwolenie na przemoc oraz wywołują dużą dezorientację, co wydaje się szczególnie niebezpieczne przy tematach związanych z polityką i dyplomacją. – Co się stanie, gdy każdy będzie mógł sprawić wrażenie, że coś wydarzyło się naprawdę, niezależnie od tego, czy tak było, czy nie? – pyta Ovadya.

Niedawno pisaliśmy o tym, jakim problemem stało się fake porn, czyli przeróbki filmów dla dorosłych, w których twarze aktorek zastępowane są wizerunkiem celebrytów lub, najczęściej w ramach wyrafinowanej zemsty, byłych partnerów. Do zalewu sieci fikcyjnymi materiałami wideo mogą też przyczynić się środowiska naukowe. Uniwersytet Waszyngtoński stworzył program pozwalający na dostosowanie nagrania audio do filmów, w których artykułowane kwestie są ściśle zsynchronizowane z ruchami ust. W efekcie manipulowanie wypowiedziami może przybrać niewyobrażalną skalę. Poniżej znajdziecie przykład takiej „zabawy” z Barackiem Obamą.

Co jeszcze? Dzięki oprogramowaniu firmy Nvidia powstają wiarygodne zdjęcia fikcyjnych celebrytów (szerzej pisaliśmy o tym tutaj). Docelowo pozwoli ono oczywiście na rzeczy bardziej użyteczne, w tym hiperrealistyczne fotografie nie tylko ludzi, ale i miejsc oraz przeróżnych obiektów.

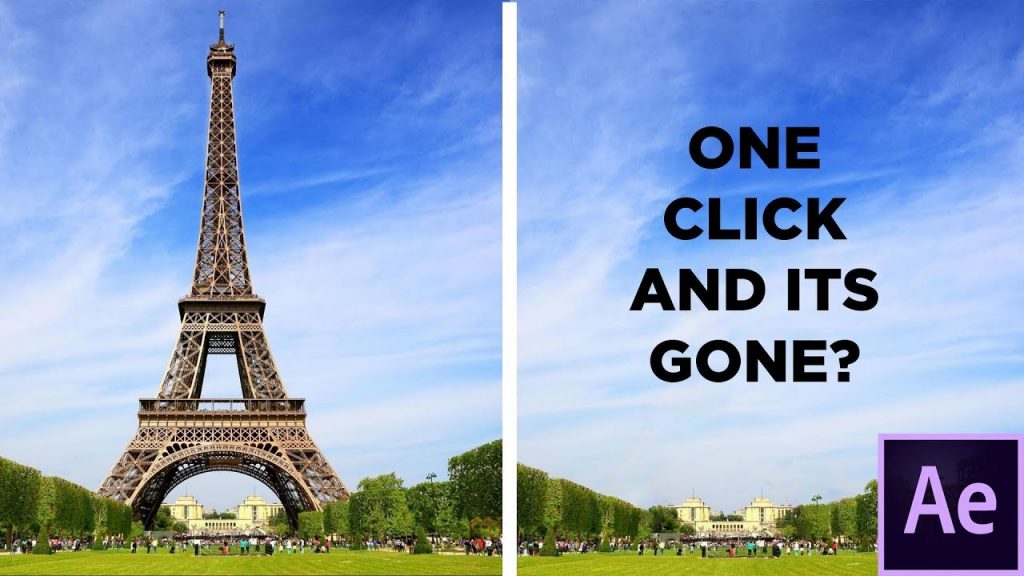

Z kolei inny gigant, Adobe, pracuje nad dwoma rozwiązaniami: Coco i Cloak. Pierwsze zapowiadane jest jako swoisty Photoshop do audio, a drugie ma pozwalać na sprawne usuwanie dowolnych elementów (w tym ludzi) z materiałów wideo.

To zaledwie przykłady najbardziej medialnego oprogramowania, bo podobnych aplikacji powstaje równolegle bardzo wiele.

Czy z tym problemem można w ogóle coś zrobić? Tęgie głowy – wśród których swoje miejsce będzie mieć także Aviv Ovadya – zabrały się do działania. W zeszłym tygodniu ogłoszono, że w czerwcu odbędzie się specjalne wydarzenie „Fake News Horror Show”, w trakcie którego technologowie i badacze będą rozważać najgorsze możliwe scenariusze, jakie mogą zrealizować się w związku z zasygnalizowanymi wyżej problemami oraz szukać sposobów na to, jak wyjść z tej sytuacji możliwie suchą stopą. Brzmi jak całkiem ciekawy szkic zawiązania akcji do fabuły jakiegoś nowego odcinka „Black Mirror”. Oby jednak zakończył się happy endem, a receptą nie były cenzorskie zapędy.

Tekst: WM

Źródło: Buzzfeed

162k

162k