Alexandria Ocasio-Cortez w bikini, czyli przyszłość AI jest tak samo niepokojąca jak my sami

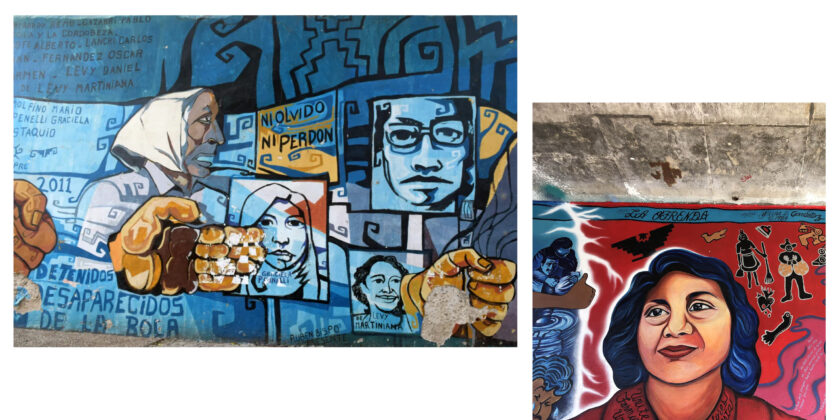

Niestety sztuczna inteligencja wcale nie jest tak inteligentna jak to wynika z jej nazwy. To, jaki będzie efekt jej pracy zależy od danych, którymi nakarmione zostaną wcześniej sieci neuronowe. A że w tym wypadku rolę nauczyciela odgrywał internet, należało się spodziewać co najmniej niepokojących wyników. Naukowcy pokazali więc algorytmowi zdjęcia portretowe różnych osób, aby ten uzupełnił ich sylwetkę.

W przypadku zdjęć przedstawiających twarz mężczyzny algorytm aż w 43 proc. decydował się na uzupełnienie jej o ciało w garniturze. Z kolei w przypadku twarzy kobiety w 53 proc. przypadków pokazywał ciało w bikini.

Tak było nawet w przypadku fotografii znanych kobiet – na przykład amerykańskiej kongresmenki Alexandrii Ocasio-Cortez. I to mimo tego, że naukowcy do celów badawczych posłużyli się fragmentem zdjęcia, na którym Ocasio-Cortez ma na sobie garsonkę.

Co więcej, gdy algorytm generował białych ludzi trzymających narzędzia, czarni ludzie trzymali… broń.

New paper in #FAccT2021! *Unsupervised* ML models learn bias (sexism, racism, ableism, intersectional) from stereotypical trends in internet images. ?゚ムヌ

Paper: https://t.co/GIoMrMq6Qr

My first paper @FAccTConference, w/ the fantastic @aylin_cim ?https://t.co/EEYlzFxlYl pic.twitter.com/a9aghjv8fX

— Ryan Steed (@ryanbsteed) January 27, 2021

Artykuł, który zalinkowany został w powyższym tweecie, ilustrowany był wygenerowanym przez algorytm zdjęciem Alexandrii Ocasio Cortez w bikini. Gdy rozpoczęła się dyskusja na jego temat na Twitterze, autorzy badania przyznali rację internautom, którzy twierdzili, że fotografia nie powinna się tam znaleźć i została ona usunięta.

Po raz kolejny okazało się, że algorytmy mogą być dokładnie tak samo rasistowskie i seksistowskie jak ludzie (mówi o tym między innymi film dokumentalny „Zakodowane uprzedzenie”, o którym szerzej pisaliśmy tutaj).

Ma to związek z danymi, którymi są one karmione. W przypadku opisywanego eksperymentu były to zdjęcia z internetu, które często seksualizują kobiety i pełne są rasowych stereotypów. Naukowcy chcieli w ten sposób pokazać, że uprzedzenia sztucznej inteligencji nie są tylko teoretycznym problemem – algorytmów używa się obecnie w wielu dziedzinach, a dane, na których się uczą, naprawdę mają znaczenie. Jeśli marzy nam się etyczna sztuczna inteligencja, musimy dbać o to, by firmy ją tworzące były transparentne, testowały swoje produkty przed ich wprowadzeniem na różne sposoby, a ci, którzy kompilują dane szkoleniowe, podchodzili do tego odpowiedzialnie.

We found race, gender, intersectional, and other biased associations in image representations learned by both iGPT and SimCLR. These biases closely match those of humans and LLMs. (4/?) pic.twitter.com/kZArDq9Ckc

— Ryan Steed (@ryanbsteed) January 26, 2021

Tekst: NS

166k

166k