Dlaczego nie wiemy, jak dokładnie działa sztuczna inteligencja?

Współczesne modele językowe, oparte na sztucznych sieciach neuronowych, stanowią jedne z najbardziej złożonych tworów technicznych, jakie kiedykolwiek powstały. Ich działanie fascynuje i jednocześnie budzi pytania o granice naszej wiedzy. Czy naprawdę rozumiemy, jak funkcjonują te systemy, które potrafią pisać, tłumaczyć, odpowiadać i tworzyć teksty nieodróżnialne od ludzkich? Odpowiedź, choć niewygodna dla zwolenników pełnej kontroli technologicznej, brzmi: częściowo tak, ale w ogromnej mierze nie.

Nasze zrozumienie jest wystarczające, by je budować i doskonalić, lecz zbyt płytkie, by w pełni pojąć, jak w środku powstaje znaczenie, sens i językowa intuicja.

Na najbardziej podstawowym poziomie sieć neuronowa to zbiór matematycznych funkcji przetwarzających liczby. Każdy węzeł, zwany neuronem, otrzymuje pewne dane wejściowe, wykonuje na nich proste obliczenia i przekazuje wynik dalej. Miliony takich połączeń tworzą warstwy, które kolejno przekształcają dane, aż na końcu powstaje wynik: słowo, zdanie, odpowiedź. Ten proces można śledzić i opisać w sposób formalny. Wiemy, jakie równania są stosowane, jakie wartości wag zostały wyuczone i jak przebiega przepływ informacji między warstwami. Jednak w praktyce to, co dzieje się wewnątrz modelu, przypomina czarną skrzynkę.

Wiemy, jakie dane wchodzą i jakie wychodzą, lecz trudniej zrozumieć, dlaczego właśnie taki wynik został uzyskany.

Wielkie modele językowe, takie jak te stosowane dziś w narzędziach opartych na architekturze transformera, operują na dziesiątkach lub setkach miliardów parametrów. Każdy z nich reprezentuje drobną część wiedzy o zależnościach między słowami, kontekstami i strukturą języka. Razem tworzą gęstą sieć statystycznych powiązań, które powstają w trakcie uczenia na ogromnych zbiorach tekstów. W efekcie model zaczyna przewidywać kolejne słowa w sposób, który imituje ludzkie myślenie. To przewidywanie jest podstawową funkcją takich systemów. Nie generują one znaczenia w sensie ludzkim, lecz raczej uczą się wzorców występowania słów i zdań. Można więc powiedzieć, że rozumieją język w sposób syntaktyczny i probabilistyczny, nie zaś semantyczny. Inżynierowie i naukowcy potrafią kontrolować proces uczenia. Wiedzą, jak zmieniać architekturę, jakie dane wybierać, jak regulować szybkość uczenia, aby model osiągał lepsze wyniki. To wiedza empiryczna, oparta na eksperymentach i doświadczeniu.

Jednak w momencie, gdy model zostanie wytrenowany, nikt nie potrafi dokładnie wskazać, gdzie i jak przechowywana jest informacja o konkretnych faktach, zasadach gramatyki czy relacjach znaczeniowych.

Próby interpretacji poszczególnych neuronów często prowadzą do niejednoznacznych wyników. Jeden neuron może reagować na różne kategorie słów, a jeden aspekt znaczeniowy może być rozproszony po tysiącach neuronów. Struktura wiedzy w modelu jest rozmyta i niepodzielna. To z jednej strony siła, bo pozwala na elastyczność i generalizację, z drugiej – ogromne wyzwanie interpretacyjne. Badacze próbują odkryć, jak modele reprezentują język. Stosuje się metody tzw. interpretowalności, które mają na celu wizualizację aktywności neuronów, analizę podobieństw między wektorami słów i identyfikację wzorców w przestrzeniach reprezentacji. Okazuje się, że w tych wielowymiarowych przestrzeniach słowa i pojęcia o podobnym znaczeniu układają się blisko siebie. Widać więc pewien ślad struktury semantycznej. Jednak im głębiej wchodzimy w sieć, tym bardziej interpretacje stają się niejasne. Na wyższych poziomach warstw powstają reprezentacje abstrakcyjne, które łączą syntaktykę, kontekst i znaczenie w sposób trudny do oddzielenia.

Można powiedzieć, że model uczy się złożonego, emergentnego języka, który jest produktem samej struktury sieci, a nie intencją programisty.

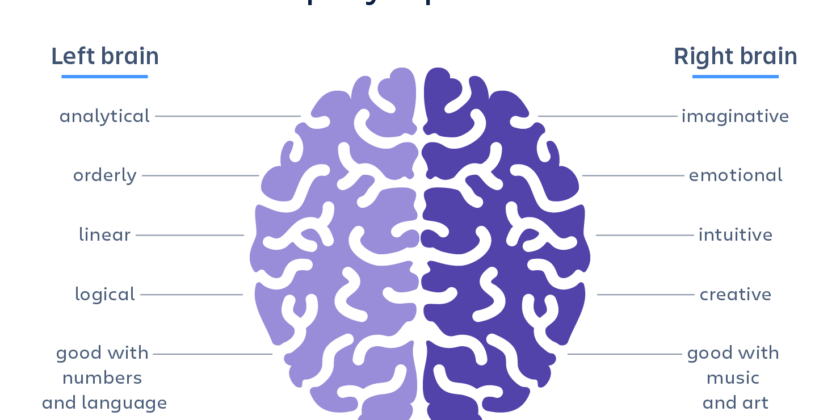

Zrozumienie działania takich systemów napotyka też granice poznawcze. Człowiek nie jest w stanie intuicyjnie ogarnąć przestrzeni o setkach miliardów wymiarów. W przeciwieństwie do małych modeli, gdzie można śledzić aktywność poszczególnych neuronów, w dużych modelach skala jest zbyt ogromna. Nie ma narzędzi, które pozwoliłyby wizualizować zależności w pełnej rozdzielczości. Dlatego badacze sięgają po uproszczenia: analizują fragmenty sieci, redukują jej wymiarowość lub wykorzystują analogie matematyczne. Każda z tych metod daje pewien wgląd, ale żadna nie oferuje pełnego obrazu. Nie oznacza to, że działanie modeli językowych jest magiczne lub niepoznawalne. To raczej kwestia złożoności. Można porównać to do rozumienia ludzkiego mózgu. Wiemy, że opiera się na impulsach elektrycznych i chemicznych reakcjach, ale nie potrafimy w pełni opisać, jak z tych procesów wyłania się świadomość czy intencja. Podobnie w przypadku modeli językowych – znamy zasady fizyczne i matematyczne, ale nie do końca rozumiemy, jak z nich rodzi się zdolność do spójnego dialogu czy kreatywnego pisania. Co więcej, modele te wykazują zachowania, których projektanci się nie spodziewali. W trakcie treningu uczą się rozwiązywać zadania, do których nie zostały bezpośrednio zaprogramowane. To zjawisko określane jest mianem emergencji. Przykładem może być zdolność do rozumienia ironii, tworzenia streszczeń czy tłumaczenia idiomów. Modele, które miały jedynie przewidywać kolejne słowo, nagle wykazują kompetencje przypominające rozumienie kontekstu. Badacze starają się zrozumieć, skąd biorą się te umiejętności. Hipotezy sugerują, że duża skala danych i złożoność architektury pozwalają na powstawanie reprezentacji, które w naturalny sposób kodują reguły języka i relacje pojęciowe. Ale dlaczego dokładnie tak się dzieje, nadal nie wiemy. Istnieje też problem epistemologiczny. Kiedy mówimy, że nie wiemy, jak działa model, nie oznacza to, że nie mamy dostępu do jego wnętrza. Cała matematyka jest znana. Niepewność wynika z tego, że nie potrafimy połączyć mikroskopowego opisu (poziomu wag i aktywacji) z makroskopowym zachowaniem (poziomem generowanego języka). To podobna trudność, jaką napotykają fizycy w próbie zrozumienia, jak z prostych równań cząsteczkowych powstaje złożona struktura biologiczna.

To nie tajemnica, lecz ograniczenie naszego sposobu poznawania złożonych systemów.

W odpowiedzi na te trudności rozwija się nowa dziedzina badań – neuronowa interpretologia, łącząca informatykę, kognitywistykę i filozofię nauki. Jej celem jest stworzenie metod, które pozwolą zrozumieć, jak modele przetwarzają znaczenie i kontekst. Jednym z kierunków jest próba budowy modeli, które są nieco mniej wydajne, ale bardziej przejrzyste. Inne podejście to symulowanie prostych zadań na miniaturowych sieciach i próba matematycznego opisania, jak powstaje reprezentacja pojęć. To przypomina pierwsze eksperymenty neurobiologiczne, w których badano pojedyncze neurony, by zrozumieć, jak działa ludzki mózg. W praktyce jednak rozwój sztucznej inteligencji odbywa się szybciej niż zdolność jej wyjaśniania. Modele rosną w skali, a nasze narzędzia poznawcze nie nadążają za nimi. Oznacza to, że w pewnym sensie ufamy systemom, których działania nie potrafimy w pełni wytłumaczyć. To sytuacja paradoksalna: korzystamy z technologii, której efekty możemy przewidzieć statystycznie, ale nie potrafimy wskazać, jak dokładnie do nich dochodzi.

53k

53k